DeepSeek本地部署详细指南

随着人工智能技术的飞速发展,本地部署大模型的需求也日益增加。DeepSeek作为一款开源且性能强大的大语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效运行模型,同时保护数据隐私。以下是详细的DeepSeek本地部署流程。

一、环境准备

(一)硬件需求

最低配置:CPU(支持AVX2指令集)+ 16GB内存 + 30GB存储。

推荐配置:NVIDIA GPU(RTX 3090或更高)+ 32GB内存 + 50GB存储。

(二)软件依赖

操作系统:Windows、macOS或Linux。

Docker:如果使用Open Web UI,需要安装Docker。

二、安装Ollama

2. Ollama 下载与安装

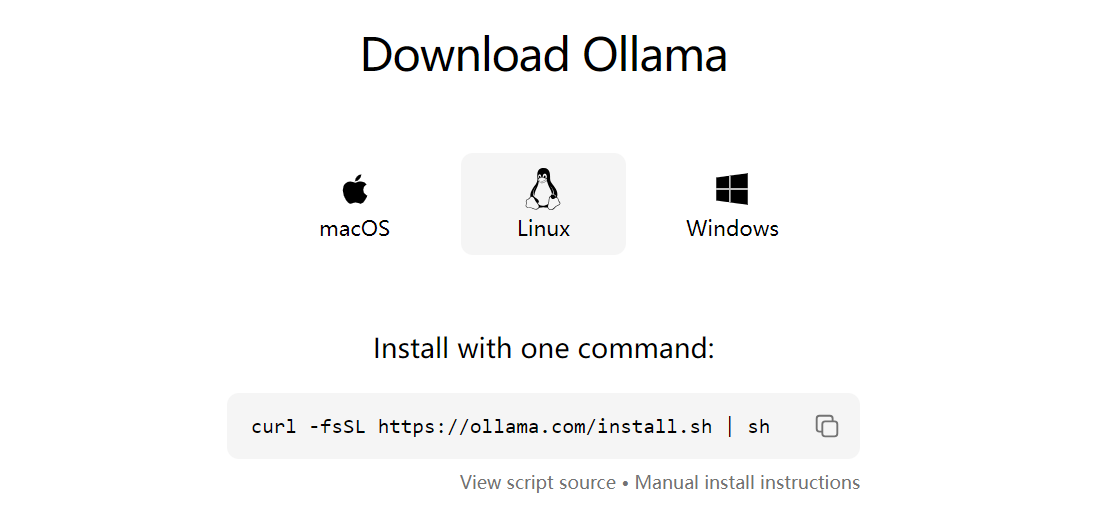

2.1 Ollama 的下载

Ollama 是一个开源的本地模型运行工具,可以方便地下载和运行各种开源模型,如 Llama、Qwen、DeepSeek 等。Ollama 提供高效、灵活的大模型部署和管理解决方案,可以简化模型的部署流程。支持macOS、Linux、Windows 操作系统。

官网地址:https://ollama.com/

下载地址:https://ollama.com/download

根据你的操作系统选择对应的安装包。windows下载完成后,直接双击安装文件并按照提示完成安装。

linux 直接在线安装即可:#curl -fsSL https://ollama.com/install.sh | sh

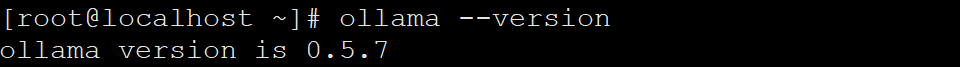

验证安装:安装完成后,在终端输入以下命令,检查Ollama版本:

ollama --version

如果输出版本号(例如ollama version is 0.5.7),则说明安装成功。

Ollama默认只允许127.0.0.1网段的ip访问,linux上面修改ollama的监听ip,允许所有ip可以访问

开启OLLAMA_HOST参数

具体的service文件设置如下

root@wanyan:~# cat /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

Environment="OLLAMA_HOST=0.0.0.0:11434"

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

[Install]

WantedBy=default.target

systemctl restart ollama

三、下载并部署DeepSeek模型

Ollama支持多种DeepSeek模型版本,用户可以根据硬件配置选择合适的模型。以下是部署步骤:

选择模型版本:

入门级:1.5B版本,适合初步测试。

中端:7B或8B版本,适合大多数消费级GPU。

高性能:14B、32B或70B版本,适合高端GPU。

下载模型:

打开终端,输入以下命令下载并运行DeepSeek模型。例如,下载7B版本的命令为:

#ollama run deepseek-r1:7b

果需要下载其他版本,可以参考以下命令:

ollama run deepseek-r1:8b # 8B版本

ollama run deepseek-r1:14b # 14B版本

ollama run deepseek-r1:32b # 32B版本

启动Ollama服务:

在终端运行以下命令启动Ollama服务:

ollama serve

服务启动后,可以通过访问 http://localhost:11434 来与模型进行交互。

四、使用Open Web UI(可选)

为了更直观地与DeepSeek模型进行交互,可以使用Open Web UI。以下是安装和使用步骤:

安装Docker:确保你的机器上已安装Docker。

运行Open Web UI:

在终端运行以下命令安装并启动Open Web UI:

安装和启动 open-webui

docker run -d -p 3000:8080 \ --add-host=host.docker.internal:host-gateway \ -v open-webui:/app/backend/data \ --name open-webui \ --restart always \ ghcr.io/open-webui/open-webui:main

安装完成后,访问 http://localhost:3000,选择deepseek-r1:latest模型即可开始使用。

五、性能优化与资源管理

资源分配:根据硬件配置选择合适的模型版本。较小的模型(如1.5B到14B)在标准硬件上表现良好,而较大的模型(如32B和70B)需要更强大的GPU支持。

内存管理:确保系统有足够的内存和存储空间,以避免运行时出现资源不足的问题。

六、常见问题及解决方法

模型下载超时:如果在下载模型时出现超时问题,可以尝试重新运行下载命令。

服务启动失败:确保Ollama服务已正确安装并启动。如果服务启动失败,可以尝试重启Ollama服务。

七、总结

通过上述步骤,你可以在本地成功部署DeepSeek模型,并通过Ollama或Open Web UI与模型进行交互。本地部署不仅能够保护数据隐私,还能根据需求灵活调整模型参数,满足不同场景下的使用需求。如果你在部署过程中遇到任何问题,可以在评论区留言,我们将一起解决。

转载请注明:IT笔记分享 » linux服务 » DeepSeek本地部署详细指南

版权声明

本站《作品展示》类文章均为原创,转载必须注明出处,技术分享类文章部分来源于网络,版权归原作者所有,若侵权请留言。